AIの電力問題に立ち向かう、富士通の省電力技術3選

Article | 2025年5月29日

この記事は約5分で読めます

生成AIをはじめとしたAI技術の発展は、あらゆる産業にビジネス変革の機会をもたらします。一方で、AIの利用の急拡大によってデータセンターの消費電力が増大し、地球環境に悪影響を与えています。この問題に立ち向かうために、富士通は、AIの計算処理を行うインフラの領域で、様々な省電力技術の研究開発を進めています。この記事では、(1)AIの計算処理でGPUの稼働効率を高める「AI Computing Broker」、(2)省電力と高性能を両立する次世代CPU「FUJITSU-MONAKA」、(3)データセンターの発熱増に対応する水冷技術の3つの技術を紹介します。

*所属・役職は掲載当時のものです。文中、敬称略

GPU稼働率を2倍にして消費電力を半減

解説:富士通 富士通研究所 コンピューティング研究所 所長 中島 耕太

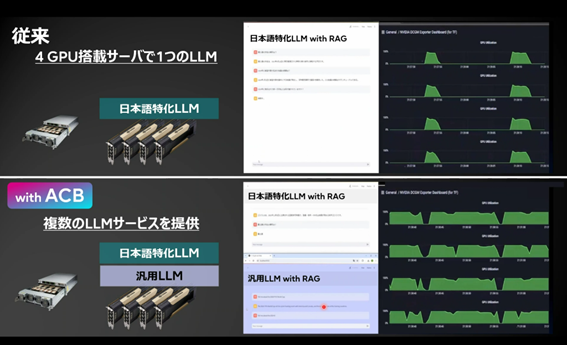

富士通が開発したAI Computing Brokerは、AIの計算処理において、GPUの稼働を2倍にするソフトウェア技術です。AIの発展と普及により、データセンターで大量のGPUが使われるようになりました。今やGPUは世界中で争奪戦になっており、供給が追いつかないほどです。AI Computing Brokerを使うと計算量あたりのGPU数を半減できるので、GPUの供給不足に対応できます。また、電力消費量も半分ですみます。AIデータセンターでGPUは非常に多くの電力を使っており、GPU数の削減は全体の省電力化に大きく影響します。

AIがデータを処理して学習や推論を行うプロセス(AIプログラム)で、GPUが使われるのは主に学習や推論の計算になります。学習や推論の前後にある前処理や後処理にはCPUが用いられますが、この間、GPUはアイドル状態で動いていません。この無駄をなくすために、CPUの処理中にGPUを元のAIプログラムから切り離して、他のAIプログラムの学習計算に割り当てるのがAI Computing Brokerの技術です。

この技術は、仮想化技術とは異なります。GPUサーバーの仮想化では、複数プログラムでGPUリソースを共有する際、GPU上のメモリも共有します。AIの学習はメモリを使うので、複数プログラムでここを共有してしまうとメモリ容量が足りなくなってしまいます。一方、AI Computing Brokerは、GPUをメモリごと切り離し他のAIプログラムに付け替えるので、メモリが問題になりません。複数のGPUサーバーがある環境では、サーバーをまたいだ付け替えが可能です。

AI Computing Brokerはソフトウェアであり、AIフレームワーク(AIの実行に必要な共通機能をまとめた“AIのOS”のようなもの)にインストールするだけでGPUの使用数を半減する仕組みが使えるようになります。パブリッククラウド環境でもオンプレミスでも利用可能で、すでに、金融、データセンター事業者、AI画像解析サービス提供者などの企業のお客様に利用いただいています。

高性能と省電力性を両立する次世代CPU

富士通 富士通研究所 先端技術開発本部 エグゼクティブディレクター 吉田 利雄

富士通は、1977年に日本初のスーパーコンピュータを開発して以来、長年にわたり世界トップクラスのスーパーコンピュータとそのCPUを開発してきました。AI時代になり、スーパーコンピュータだけでなく、あらゆるデータセンターで高性能且つ省電力のコンピューティングが求められています。

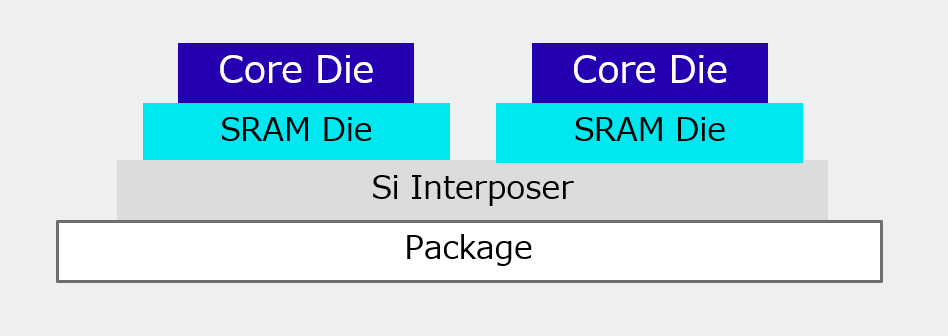

FUJITSU-MONAKA(※1)は、富士通が開発を進めている高性能と省電力性を両立した次世代CPUです。データセンターをはじめとした様々な領域での利用を見込み、2027年の出荷開始を目指しています。高性能と省電力性を両立するために、スーパーコンピュータ「京」と「富岳」(※2)で培ったマイクロアーキテクチャ、低電圧技術などの富士通独自の技術をさらに進化させています。

具体的には、半導体回路を“2階建て”の3D構造にする「3Dメニ―コア」というアーキテクチャを採用しました。2階建てにすることでデータの移動を少なくし、低遅延と高スループットを実現しています。また、半導体の製造プロセスも独自の工夫があります。2階部分(トップダイ)には、より省電力を実現できる最先端の2ナノメートルプロセスを採用、1階部分(ボトムダイ)は低コストの5ナノメートルプロセスを採用するハイブリッド構成により、省電力化、低コスト化しています。

超低電圧で安定動作する点もFUJITSU-MONAKAの特徴です。通常、CPUの電源電圧を下げると回路スピードが遅くなり、さらに安定動作が難しくなるのですが、富士通独自の回路設計によりこれらを克服しました。CPUの電源電圧を下げると、その分消費電力も少なくなります。これらの独自技術により、FUJITSU-MONAKAは競合比で2倍のアプリケーション性能(※3)と、2倍の電力効率(※3)を実現します。

※1) FUJITSU-MONAKA:この成果は、NEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)の助成事業の結果得られたものです。

※2) スーパーコンピュータ「京」や「富岳」:理化学研究所と富士通が共同開発。

※3) 2027年リリース時期を想定した当社性能推定値に基づく。性能は、使用状況、構成、その他の要因によって異なります。

AI時代に必須の水冷化トレンドと、富士通の卓越した水冷技術の知見

解説:富士通 ミッションクリティカルシステム事業本部 サステナブルテクノロジー事業部 シニアディレクター 荒滝 新菜/ シニアディレクター 前田 秀樹

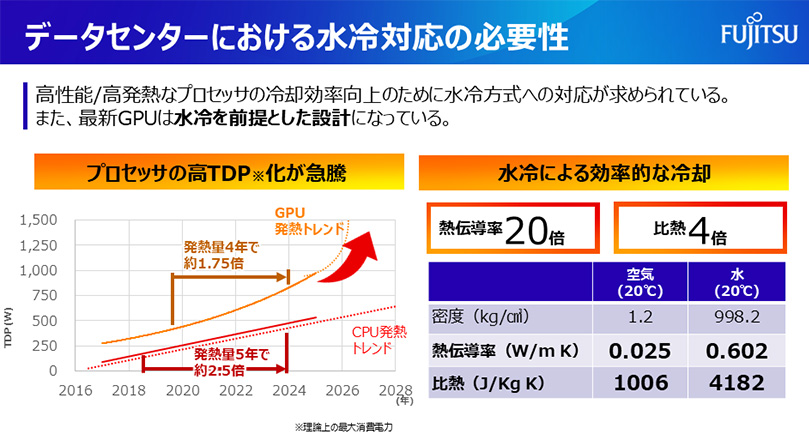

AIの急速な普及に伴うコンピューティング需要、特にAIの処理を担うGPUの演算量の急増は、データセンターの電力需要の増大と共に、サーバーやラックからの発熱量の増加も引き起こしています。GPUを故障させず稼働させるために温度を低く保つ必要がありますが、この冷却にも電力を使います。2025年にリリースされる最新世代のGPUは水冷が必須となっています。そのような背景から、今、データセンターの発熱増に対応し、冷却電力を削減する技術として、従来の空冷よりも冷却効率の高い「水冷」が注目されています。

水冷とは、空気よりも熱伝導率が20倍以上高い水を使って、効率よくサーバーやラックを冷却する技術です。主な水冷の方式には、サーバー内のプロセッサに水冷装置(内部を冷却水が循環)を直接接触させて熱を逃がす「直接液体冷却(DLC:Direct Liquid Cooling)」、サーバーが集積されたラックの背面側に水冷装置を設置して排熱を冷やす「(水冷)リアドア空調」などがあります。

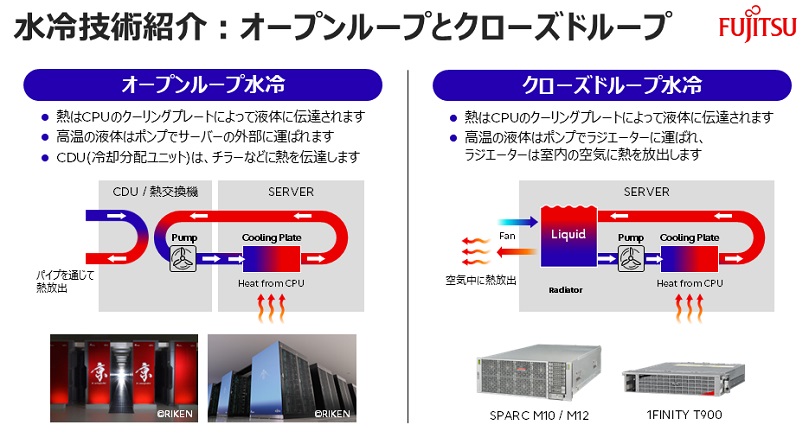

直接液体冷却には、冷却によって高温になった冷却水をサーバー外部に運び出す「オープンループ水冷」と、高温になった液体をサーバー内部のラジエーターに運んでラジエーターから室内の空気に熱を放出する「クローズドループ水冷」の2通りの方式があります。富士通はどちらの技術も持っていますが、特にクローズドループ水冷においては、冷却水を沸騰させて気化熱で冷却する「沸騰冷却(2相冷却)」という世界初の技術を開発し、ミッションクリティカル向けに2017年に量産化し提供しています。冷却性能は、水だけの(1相式)クローズドループ水冷の2倍に向上しました。絶縁冷媒を使った2相式冷却に比べ環境負荷を低減し、人的安全性も担保する技術となっています。

オープンループ水冷はCDU(Coolant Distribution Unit)を介して、クーリングタワー(冷却塔)やチラー(冷水装置)にサーバーの高温の液体を運び冷却します。サーバーの熱を液体を使って建物の外まで運ぶためラックに高密度にサーバーを実装することが可能であり、一般的なGPUサーバーの多くはこの方式を採用しています。富士通のサーバーシステムを停止させない設計思想を取り入れすべてのUnitの冗長化を実現しています。

水冷向けITインフラ機器は存在していますが、実際の導入となると水漏れによる機器の破損や階下電気設備への影響、また、水冷のための最適な設備投資の見極め、水冷設備の保守運用ノウハウの課題から踏み切れない企業が多数です。

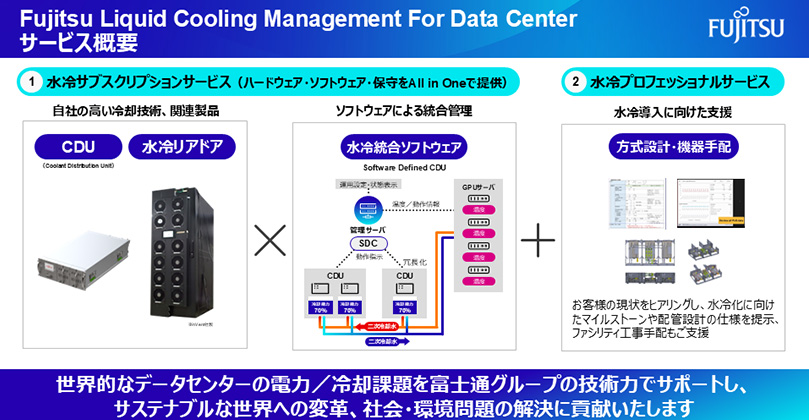

このような企業の課題を解決するために、富士通ではこれまでの水冷技術とノウハウ活用し、お客様の将来のサーバー増設計画に合わせた最適な冷却ファシリティ(水冷塔やチラー、配管)の設計と導入をプロフェッショナルサービスとして支援致します。また、初期投資や運用課題に対し水冷ハードウェアと複数のCDUなどを統合管理し自動制御するソフトウェア、機器の導入と運用をAll-in-oneでサブスクリプションサービスとして提供いたします。(「Fujitsu Liquid Cooling Management for Datacenter」として2025年度第1四半期に提供予定)水冷ソフトウェアは、水冷ハードウェアとサーバーをリアルタイム監視し、複数のCDUなどを水冷監視制御し、冷却システム全体の高信頼性・高可用性・高効率性を実現します。データセンター事業者、自社データセンターを持つ企業だけでなく、データセンターを建てる建設会社にもこれらサービスを提供していきます。

世界トップクラスのGPUサーバーベンダである Super Micro Computer, Inc. 社と、ラックマウント型のCDUベンダであるニデック株式会社と協力し、当社の館林データセンターでソリューションの効果検証を行い、2025年度第4四半期までに世界トップレベルのPUE(Power Usage Effectiveness)*をお客様が目指せるデータセンター環境の提供を目指します。

* PUEとはPower Usage Effectivenessの略で、データセンターの電力使用効率を示す指標。データセンター全体の消費電力をIT機器の消費電力で割った値。理想値は1.0でデータセンターの全電力をIT機器に投入している状態となります。

中島 耕太

Kouta Nakashima

富士通株式会社 富士通研究所 コンピューティング研究所 所長

2002年富士通研究所に入社。以来、PCクラスタ高速化技術、高速ネットワーク制御技術等のHigh Performance Computing(HPC)技術の研究開発に従事。2023年より現職につく。

吉田 利雄

Yoshida Toshio

富士通株式会社 富士通研究所 先端技術開発本部 エグゼクティブディレクター

1999年に富士通株式会社に入社、一貫して最先端CPU開発に従事。HPC/AI/データセンター向けプロセッサアーキテクチャのスペシャリストとして、UNIXサーバやスーパーコンピュータ「京」/「富岳」向けCPUの開発を牽引。現在は、高性能・省電力プロセッサ「FUJITSU-MONAKA」の開発責任者としてプロジェクトをリード。

荒滝 新菜

Nina Arataki

富士通株式会社 プラットフォームBG ミッションクリティカルシステム事業本部 シニアディレクター

プロダクトエンジニアとしてハードウェア・ソフトウェア・クラウド開発で独自技術の製品化を担い特許35件出願や業界団体もリード。富士通AI事業や海外拠点の立ち上げ、他社アライアンスによるビジネス開拓を担う

前田 秀樹

Hideki Maeda

富士通株式会社 プラットフォームBG ミッションクリティカルシステム事業本部 シニアディレクター

入社以来、一貫してミッションクリティカルサーバやスーパーコンピュータの冷却技術開発に従事。空冷、液冷、液浸などのあらゆる冷却技術の製品化を経験。現在、冷却技術を中心にデータセンターの省電力ビジネスをリードしている。

関連コンテンツ

GPU不足の解決に挑む!AI computing broker開発の裏側に迫る

富士通とSupermicro、省電力高性能プロセッサや水冷技術によるグリーンなAIコンピューティングの提供に向け戦略的協業を開始

富士通、Supermicro社との提携を拡大し生成AIの活用基盤をトータル提供開始

機密性の高いデータを安心安全にプライベート領域で管理し、オンデマンドに生成AIを利活用可能な「Fujitsu クラウドサービス Generative AI Platform」を提供